En marzo de 2021, el FBI avisó que los deepfakes (suplantación del rostro y/o la voz), pueden ser la próxima ciberamenaza importante. ¿En qué se basan? Según esta agencia federal de investigación, las amenazas incluyen personalidades corporativas sintéticas o sofisticadas simulaciones de un empleado real. ¿Cuáles son las consecuencias para las empresas pequeñas?

En marzo de 2021, el FBI avisó que los deepfakes (suplantación del rostro y/o la voz), pueden ser la próxima ciberamenaza importante. ¿En qué se basan? Según esta agencia federal de investigación, las amenazas incluyen personalidades corporativas sintéticas o sofisticadas simulaciones de un empleado real. ¿Cuáles son las consecuencias para las empresas pequeñas?

Aunque los deepfakes actualmente no desempeñan un papel importante en la ingeniería social, incluso el Foro Económico Mundial ha empezado a prestar más atención a esta tecnología, cuya aplicación crece en volumen y cada vez es más sofisticada, por lo que ha marcado esta tendencia como algo que potencialmente podría dañar a las empresas. Muchos otros expertos comparten este punto de vista. Según un informe realizado por CyberCube, este tipo de suplantaciones podrían convertirse en una amenaza importante para las empresas durante los próximos dos o tres años.

Cada vez es más fácil crear deepfakes, se necesitan menos imágenes de origen para crearlas, y cada vez se comercializan más. Infórmate sobre el posible uso de esta tecnología desde el punto de vista de la ingeniería social. ¿Dónde podrían suponer un riesgo los deepfakes?

1) Una forma muy convincente de suplantación

Uno de los primeros casos de esta técnica ocurrió hace dos años. En agosto de 2019, los cibercriminales engañaron a una empresa para que hiciera una transferencia bancaria de 207688,45 euros utilizando un deepfake de la voz de su CEO accionado por inteligencia artificial. Después, la víctima explicó que la persona que llamó había reproducido de manera convincente el acento alemán y el tono de voz del empresario. En este caso, el ciberdelincuente no tuvo que esforzarse en hacer un vídeo: solo tenía que hacer una llamada telefónica.

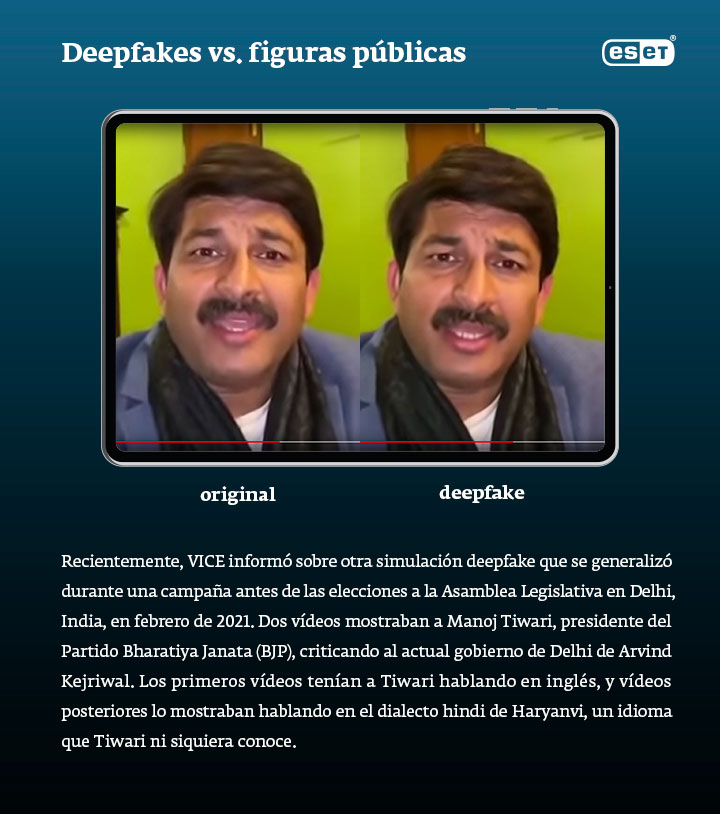

Aunque muchos vídeos populares de esta estafa son intercambios de rostros completos (face swaps), otra posibilidad es crearlo a partir de un vídeo que ya existe. Con un algoritmo de sincronización de labios, se puede utilizar una grabación de audio de una persona real para que el algoritmo aprenda a convertir los sonidos en formas básicas de la boca. Esta tecnología podría utilizarse para poner palabras en la boca de un CEO, de proveedores importantes o de un empleado para que pidan a sus colegas que transfieran dinero o que compartan sus credenciales de inicio de sesión. Mientras tanto, estos ataques probablemente tendrán por objetivo a ejecutivos para dañar la reputación de la empresa.

2) La sextorsión en su peor cara

La revista VICE afirmaba hace poco que, desde que los deepfakes surgieron en 2017, la tecnología se ha utilizado extensamente para crear contenido pornográfico falso a partir de secuencias de vídeos de celebridades y algoritmos de inteligencia artificial. Pero también ha habido ya varios casos en los que se ha insertado a personas no célebres (principalmente mujeres) en esos vídeos falsos para, a continuación, chantajearlas. Ellas ni siquiera han tenido que hacer nada malo: hasta que se revela el verdadero origen del vídeo, el contenido puede causar un gran dolor y daños en la reputación.

Sin embargo, no sirve de nada asustar a tu personal con estos ejemplos. En su lugar, explícales por qué es importante ser cuidadoso con la información que comparten en línea, ahora más que nunca. Actualmente, la credibilidad de los vídeos falsos varía en función del número de fotografías y vídeos que se ha utilizado en el software para crear la simulación. Por lo tanto, todo el mundo puede empezar a evitarse problemas controlando su presencia digital y el número de fotografías que comparten en línea.

3) Nuevas situaciones que la gente no puede ignorar

Según Cyberscout, uno de los factores que limitan la difusión de deepfakes es que los estafadores no los necesitan todavía. De momento, a los ciberdelincuentes les sigue yendo muy bien con los tipos existentes de ataques de ingeniería social, que también se pueden interpretar como carencias en la formación sobre ciberseguridad de las empresas. Pero cuando la mayoría de las empresas vayan al grano y empiecen a formar a su plantilla con regularidad y la protección multicapa de ciberseguridad sea lo más habitual, entonces la manera más eficaz de llamar la atención de la gente y forzarles a hacer algo será fingir que se es alguien de confianza y hacerles creer que están haciendo lo correcto.

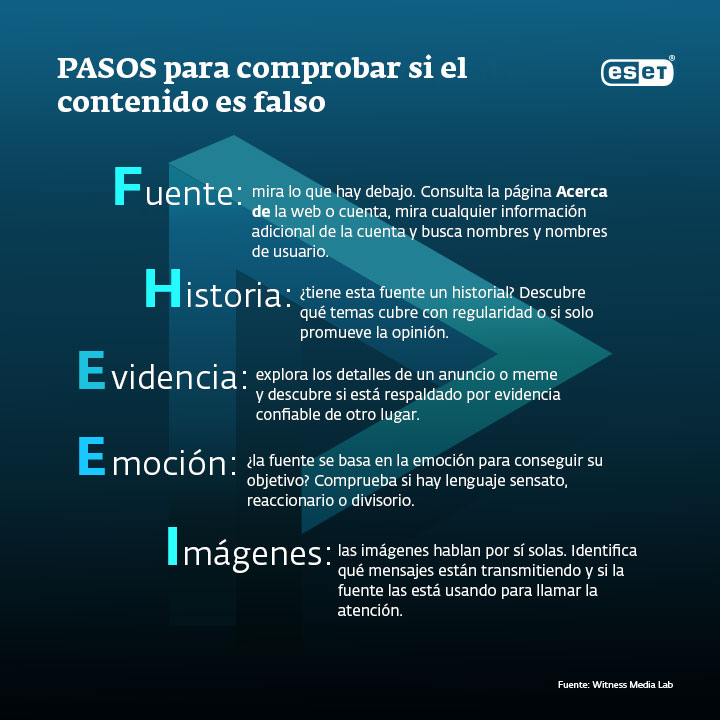

Cómo no caer en esta estafa

Para protegerte a ti mismo y a tu empresa de los efectos de esos fraudes, es buena idea saber en qué situaciones pueden producirse esos ataques. El FBI explica que podemos esperar nuevos escenarios para los ataques en situaciones como las reuniones remotas, y que hay que poner manos a la obra para ofrecer formación a los empleados enseñándoles técnicas de verificación eficaces y reconocimiento de los errores que se pueden detectar en las fotografías o vídeos de deepfakes. Pese a que tanto el FBI como los expertos de TI creen que inevitablemente disminuirán los obstáculos para los estafadores que quieren crear un fraude digital convincente, esa formación como mínimo puede ayudar a los usuarios de TI a comprender mejor el contexto en el que aparecen los deepfakes y qué pueden hacer.

Herramientas como la plataforma de verificación de la organización Sensity. AI o Reality Defender, un plug-in para el navegador que detecta vídeos falsos, se pueden utilizar para rechazar los deepfakes. También hay varias medidas de seguridad que puedes implementar para impedir la manipulación de tus contenidos o datos confidenciales, como añadir píxeles de ruido a tus vídeos para desactivar las modificaciones, o analizar fotogramas o el espectro acústico para detectar distorsiones en vídeos de deepfakes.

Esta estafa está lentamente empezando a poner a prueba la resiliencia de las personas, y ha llegado el momento de reforzar el sistema inmunitario de tus comunicaciones y sistemas informáticos.